🧩 5. Reducción de Dimensionalidad

Ejemplos: PCA (Análisis de Componentes Principales), t-SNE, UMAP.

Uso: Fundamental para visualizar datos de alta dimensión, haciéndolos más comprensibles. También es un paso clave de preprocesamiento para eliminar ruido o multicolinealidad antes de aplicar otros modelos.

Ventajas: Puede mejorar significativamente el rendimiento y la velocidad de otros algoritmos de machine learning.

Limitaciones: A veces se pierde la interpretabilidad de los datos originales y no siempre garantiza una mejora en el desempeño de los modelos.

Flexible Discriminant Analysis (FDA)

Flexible Discriminant Analysis (FDA) es un método de clasificación que generaliza el Análisis Discriminante Lineal (LDA) para manejar relaciones no lineales entre las variables predictoras y las clases. A diferencia de LDA, que asume límites de decisión lineales y distribuciones gaussianas con matrices de covarianza iguales, FDA es mucho más adaptable.

FDA logra esta flexibilidad al combinar dos conceptos: 1. Optimal Scoring: Transforma las variables de respuesta categóricas en valores numéricos (scores óptimos) de manera que las clases sean más fácilmente separables linealmente. 2. Modelos de Regresión No Paramétricos: En lugar de usar una regresión lineal simple (como en LDA), FDA utiliza métodos de regresión no paramétricos más flexibles, como las Multivariate Adaptive Regression Splines (MARS). Esto permite que la relación entre las variables transformadas y los scores óptimos sea no lineal, lo que a su vez se traduce en fronteras de decisión no lineales en el espacio original de los datos.

Es decir, FDA toma los datos, los transforma de una manera inteligente para que sean más fáciles de separar, y luego aplica una discriminación lineal en ese espacio transformado, lo que resulta en una frontera de decisión compleja y flexible en el espacio original.

En el contexto del aprendizaje global vs. local, FDA se considera un modelo que integra aspectos de ambos.

Aspecto Global: El objetivo final de FDA es encontrar una función discriminante global que separe las clases en el espacio transformado. Los scores óptimos y las funciones base del método de regresión (como MARS) se aprenden considerando la estructura general de los datos para lograr la mejor separación a nivel global. El modelo resultante es una función que se aplica de manera consistente a cualquier nueva observación.

Aspecto Local (debido al uso de modelos no paramétricos como MARS): La flexibilidad de FDA proviene de su uso de métodos como MARS, que dividen el espacio de las características en regiones locales y ajustan relaciones simples dentro de cada una. Esto permite que el modelo se adapte a no linealidades y a cambios en la relación entre las variables en diferentes partes del espacio de datos. Así, si los datos no se distribuyen linealmente, FDA puede construir fronteras de decisión que capturan esas complejidades al “localizar” las relaciones importantes.

| Guía rápida para elegir FDA | ||

| Flexible Discriminant Analysis (FDA) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

Linear Discriminant Analysis (LDA)

El Análisis Discriminante Lineal (LDA) es un método de clasificación y reducción de dimensionalidad utilizado para encontrar una combinación lineal de características que mejor separe dos o más clases de objetos o eventos. Su objetivo principal es modelar la diferencia entre las clases, lo que lo hace muy útil para tareas de clasificación supervisada.

LDA funciona proyectando los puntos de datos a un espacio de menor dimensión (generalmente una o pocas dimensiones) de tal manera que las clases estén lo más separadas posible. Para lograr esto, busca una dirección (un eje) que maximice la separación entre las medias de las clases (varianza entre clases) mientras minimiza la varianza dentro de cada clase (varianza intraclase). En un problema de clasificación binaria, esto significa encontrar la línea óptima para proyectar los datos de modo que las dos clases se superpongan lo menos posible.

A diferencia de modelos como la Regresión Logística, que buscan modelar la probabilidad de pertenencia a una clase, LDA modela directamente la distribución de los datos dentro de cada clase y luego utiliza el Teorema de Bayes para asignar una nueva observación a la clase más probable. LDA asume que las varianzas (o matrices de covarianza) de las clases son iguales y que los datos están distribuidos normalmente.

Aprendizaje Global vs. Local:

El Análisis Discriminante Lineal (LDA) es un modelo de aprendizaje puramente global.

- Aspecto Global: LDA busca una única transformación lineal o un conjunto de direcciones (ejes) que se aplican a todos los datos para lograr la máxima separación entre las clases en un espacio de menor dimensión. La frontera de decisión que resulta de LDA es siempre lineal y se define globalmente a partir de las medias y las varianzas combinadas (asumidas como iguales) de todas las clases. El modelo es “fijo” y se aplica uniformemente a cualquier nueva observación, sin importar su ubicación específica en el espacio de características. No se ajustan modelos diferentes para distintos vecindarios de datos, sino que se aprende una regla de separación que es válida para todo el dominio.

Por lo tanto, si los datos no se distribuyen linealmente o las fronteras de decisión entre las clases son inherentemente no lineales (por ejemplo, si una clase rodea a otra), LDA puede no ser el método más adecuado. En esos escenarios, modelos de aprendizaje local o más flexibles (como los árboles de decisión, SVM con kernels no lineales, o FDA que extiende LDA para no linealidades) suelen ofrecer un mejor rendimiento.

| Guía rápida para elegir LDA | ||

| Linear Discriminant Analysis (LDA) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

Mixture Discriminant Analysis (MDA)

El Análisis Discriminante de Mezclas (MDA) es una extensión del Análisis Discriminante Lineal (LDA) y del Análisis Discriminante Cuadrático (QDA) que aborda la limitación de que estas técnicas asumen que cada clase proviene de una única distribución normal (o gaussiana). MDA relaja esta suposición al permitir que cada clase sea modelada como una mezcla de múltiples distribuciones gaussianas. Esto le otorga una capacidad significativamente mayor para manejar clases con formas complejas o multimodales, que no pueden ser descritas adecuadamente por una sola distribución normal.

MDA funciona de la siguiente manera:

-

Modelado por Componentes de Mezcla: Para cada clase, MDA estima los parámetros (media y matriz de covarianza) de varias distribuciones gaussianas (“componentes de mezcla”) en lugar de solo una. Es similar al proceso de agrupamiento de mezclas gaussianas (Gaussian Mixture Models - GMM) aplicado dentro de cada clase.

-

Asignación a la Clase: Una vez que se han modelado las distribuciones de mezcla para cada clase, para una nueva observación, MDA calcula la probabilidad de que esa observación pertenezca a cada componente de mezcla en cada clase. Luego, asigna la observación a la clase que maximiza la probabilidad posterior, es decir, la clase que es más probable que haya generado esa observación.

- Fronteras de Decisión Flexibles: Al modelar cada clase como una mezcla de gaussianas, MDA puede generar fronteras de decisión que son mucho más flexibles y no lineales que las de LDA (que son lineales) o QDA (que son cuadráticas). Esto le permite adaptarse a clases con estructuras complejas, que pueden tener “agrupaciones” internas o formas irregulares.

Los parámetros del modelo (las medias, covarianzas y pesos de los componentes de mezcla para cada clase) se suelen estimar utilizando un algoritmo iterativo como la Maximización de Expectativas (Expectation-Maximization - EM).

Aprendizaje Global vs. Local:

El Análisis Discriminante de Mezclas (MDA) se encuentra en un punto intermedio, inclinándose hacia un modelo que combina aspectos de aprendizaje global y local, con una mayor flexibilidad para capturar la estructura local de los datos en comparación con LDA o QDA.

Aspecto Global: Al igual que LDA, el objetivo final de MDA es crear un clasificador global que pueda asignar cualquier nueva observación a una de las clases. Las distribuciones de mezcla para cada clase se aprenden a partir de todo el conjunto de datos de entrenamiento para esas clases, y el clasificador resultante se aplica de manera consistente en todo el espacio de características. La regla de decisión final es una función que se deriva de las distribuciones aprendidas para todas las clases.

Aspecto Local: La “flexibilidad” de MDA y su capacidad para manejar no linealidades proviene de su suposición de que cada clase puede estar compuesta por múltiples componentes gaussianos. Esto significa que, dentro de una misma clase, puede haber sub-agrupaciones o densidades locales que son modeladas individualmente. Al permitir estas múltiples distribuciones gaussianas dentro de cada clase, MDA puede adaptarse mejor a las características y densidades de los datos en diferentes vecindarios o subregiones del espacio de características. Si los datos no se distribuyen linealmente y tienen formas complejas (como clusters separados dentro de una clase), MDA puede “localizar” y modelar estas estructuras, llevando a fronteras de decisión mucho más complejas y no lineales que se ajustan mejor a la forma real de las clases.

| Guía rápida para elegir MDA | ||

| Mixture Discriminant Analysis (MDA) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

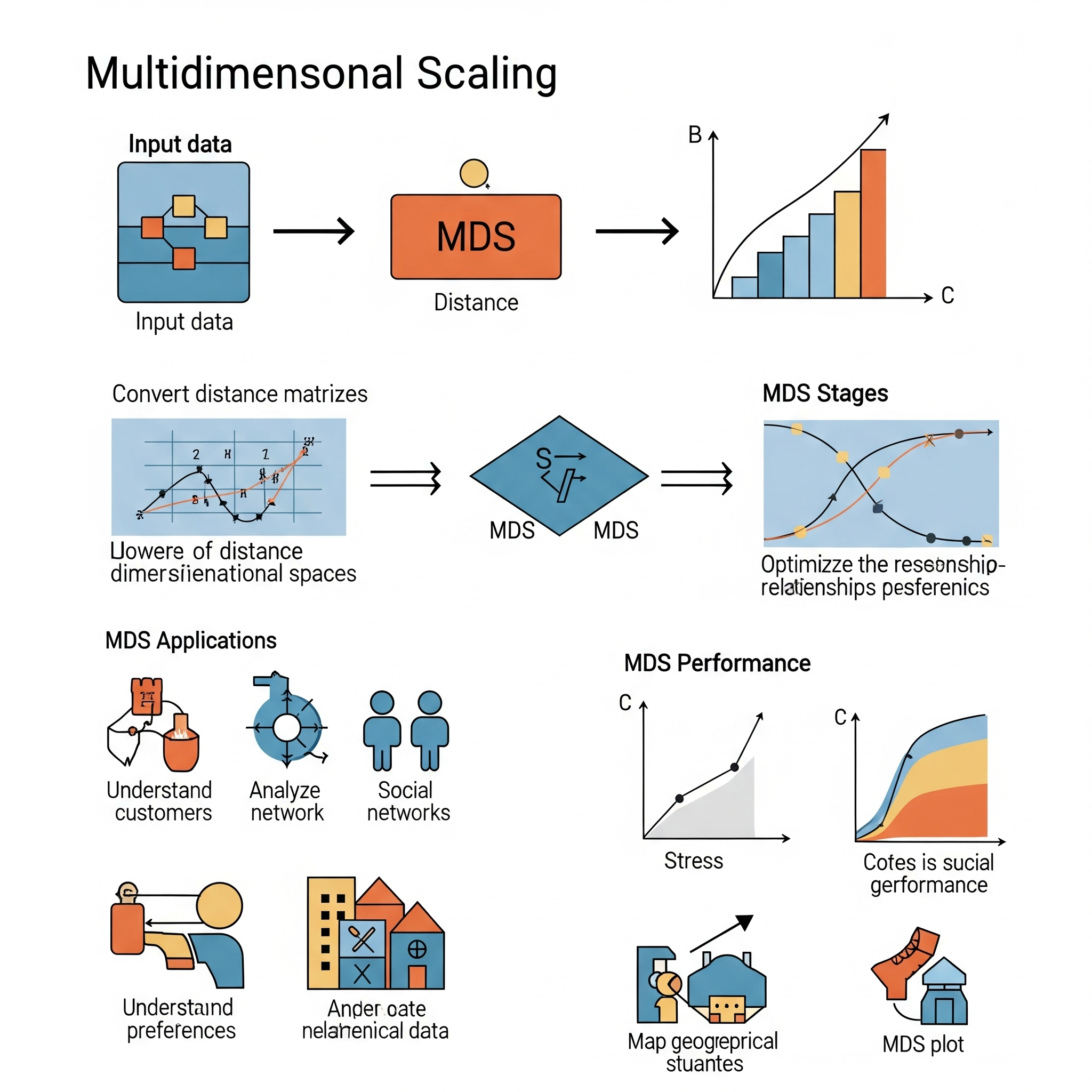

Multidimensional Scaling (MDS)

El Escalamiento Multidimensional (MDS) es una técnica de reducción de dimensionalidad utilizada para visualizar y explorar las similitudes o disimilitudes entre un conjunto de objetos. Su objetivo principal es tomar datos de alta dimensión, donde las relaciones entre los puntos pueden ser difíciles de entender, y representarlos en un espacio de menor dimensión (típicamente 2D o 3D) de tal manera que las distancias entre los puntos en el nuevo espacio reflejen lo más fielmente posible las distancias (o disimilitudes) originales entre los objetos.

Imagina que tienes una tabla de distancias de viaje entre varias ciudades. MDS intentaría dibujar un mapa de esas ciudades donde las distancias en el mapa se correspondieran lo más posible con las distancias de la tabla.

El proceso general de MDS implica:

-

Matriz de Disimilitud: Se necesita una matriz que contenga las disimilitudes (distancias) entre cada par de objetos. Estas disimilitudes pueden ser distancias euclidianas, correlaciones, o cualquier otra medida de qué tan diferentes (o similares) son dos objetos.

-

Optimización: El algoritmo busca una configuración de puntos en el espacio de menor dimensión que minimice una función de “estrés” o “ajuste”. Esta función mide qué tan bien las distancias en el espacio reducido se corresponden con las disimilitudes originales. Una función de estrés baja indica un buen ajuste.

- Visualización: Los puntos resultantes en el espacio de menor dimensión pueden ser graficados para revelar patrones, clusters o la estructura subyacente de los datos que no eran evidentes en las dimensiones originales.

Existen varias variantes de MDS, como el MDS Clásico (o Métrica), que asume que las disimilitudes son distancias euclidianas y busca una solución analítica, y el MDS No-Métrico, que solo busca preservar el orden de las disimilitudes (es decir, si A es más diferente de B que de C, esa relación se mantendrá en el espacio reducido, sin que las distancias exactas tengan que ser iguales).

Aprendizaje Global vs. Local:

El Escalamiento Multidimensional (MDS) se considera predominantemente una técnica de aprendizaje global.

- Aspecto Global: MDS busca una configuración única de puntos en el espacio de baja dimensión que optimice el ajuste de todas las disimilitudes en el conjunto de datos de manera simultánea. La función de estrés que se minimiza considera las distancias entre todos los pares de puntos, buscando una solución que sea globalmente la mejor representación de esas relaciones. El objetivo es preservar la estructura general de las distancias en el conjunto de datos completo, no solo las relaciones en vecindarios específicos. La solución que se encuentra es una “vista aérea” o un “mapa” de las relaciones de todo el conjunto de datos.

Aunque las disimilitudes originales son “locales” en el sentido de que son medidas entre pares de puntos, la forma en que MDS utiliza todas estas medidas para construir un mapa coherente y de baja dimensión es un proceso global de optimización. No se ajustan modelos separados para diferentes subconjuntos de datos; en su lugar, se busca una representación unificada que capture la estructura general de similaridad/disimilitud de todos los datos. Por lo tanto, si los datos tienen una estructura global bien definida basada en distancias, MDS es una herramienta efectiva para revelar esa estructura.

| Guía rápida para elegir MDS | ||

| Multidimensional Scaling (MDS) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

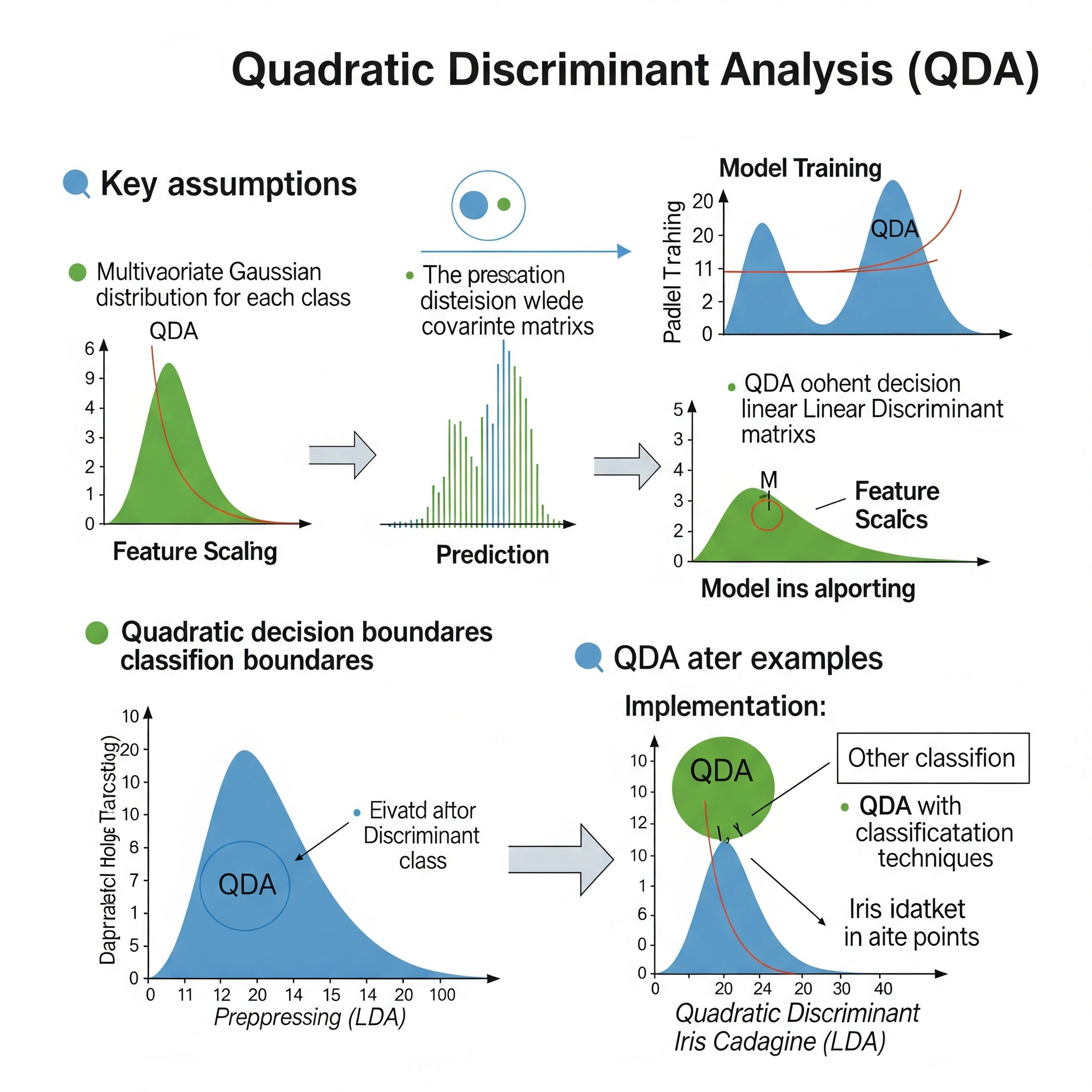

Quadratic Discriminant Analysis (QDA)

El Análisis Discriminante Cuadrático (QDA) es un método de clasificación que, al igual que el Análisis Discriminante Lineal (LDA), modela la distribución de cada clase para clasificar nuevas observaciones. Sin embargo, QDA es una extensión de LDA que relaja una de sus suposiciones clave: mientras que LDA asume que todas las clases comparten la misma matriz de covarianza (es decir, las distribuciones tienen la misma “forma” o “orientación”), QDA permite que cada clase tenga su propia matriz de covarianza distinta.

Esta diferencia es fundamental:

* LDA: Asume que la variación de los datos es la misma en todas las clases, lo que resulta en fronteras de decisión lineales entre las clases.

* QDA: Permite que la variación de los datos sea diferente para cada clase, lo que resulta en fronteras de decisión cuadráticas entre las clases. Esto significa que las fronteras de decisión pueden ser curvas (elipsoides, parábolas, hipérbolas), lo que permite a QDA modelar relaciones más complejas y no lineales entre las variables y las clases.

El funcionamiento de QDA implica:

1. Modelado de Distribuciones: Para cada clase, QDA estima la media y la matriz de covarianza específicas de esa clase, asumiendo una distribución normal multivariada.

2. Clasificación: Para una nueva observación, QDA calcula la probabilidad de que esa observación provenga de cada clase, utilizando las distribuciones normales modeladas para cada clase. Luego, asigna la observación a la clase con la probabilidad posterior más alta (aplicando el Teorema de Bayes).

Aprendizaje Global vs. Local:

El Análisis Discriminante Cuadrático (QDA) es, al igual que LDA, un modelo de aprendizaje global.

Aspecto Global: QDA construye un clasificador global basado en las distribuciones de probabilidad aprendidas para cada clase. Las medias y las matrices de covarianza se estiman a partir de todo el conjunto de datos de entrenamiento para cada clase, y estos parámetros definen una función discriminante que se aplica de manera uniforme a cualquier nueva observación en el espacio de características. La frontera de decisión, aunque cuadrática y no lineal, es una única función matemática definida a nivel global por los parámetros del modelo. No se ajustan modelos separados para diferentes vecindarios de datos.

Mayor Flexibilidad Globalmente: Aunque sigue siendo un modelo global, la capacidad de QDA para tener matrices de covarianza separadas para cada clase le otorga una mayor flexibilidad para adaptarse a formas de clase más diversas en comparación con LDA. Esto significa que QDA puede modelar situaciones donde las clases tienen diferentes orientaciones o dispersiones en el espacio de características, lo que resulta en fronteras de decisión que pueden capturar ciertas no linealidades de manera global. Sin embargo, sigue asumiendo distribuciones gaussianas para cada clase y una forma cuadrática para las fronteras, lo que puede ser una limitación si la verdadera complejidad de los datos es aún mayor o no se ajusta a estas suposiciones.

| Guía rápida para elegir QDA | ||

| Quadratic Discriminant Analysis (QDA) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

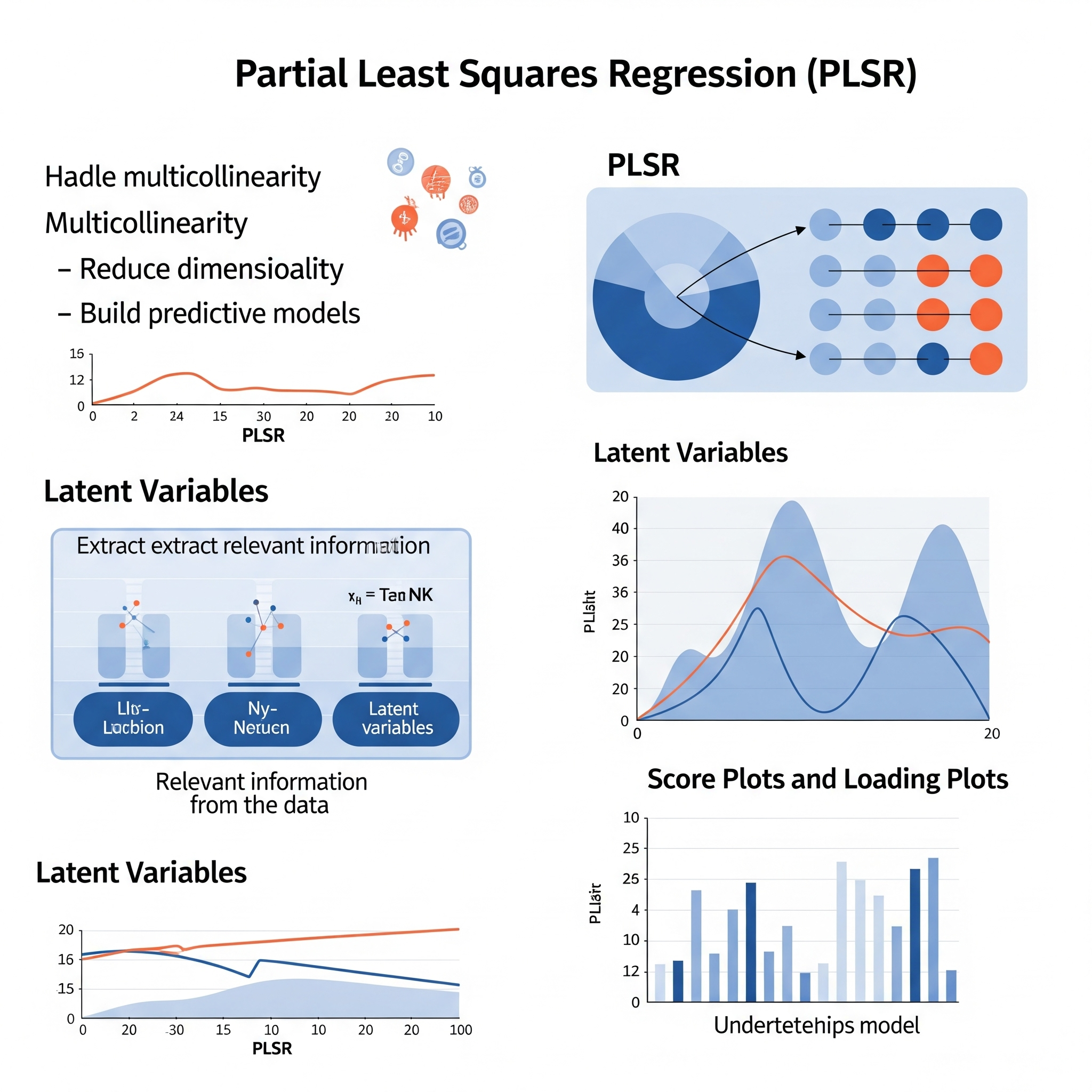

Partial Least Squares Regression (PLSR)

Partial Least Squares Regression (PLSR) es una técnica de regresión multivariada que combina características de la regresión por mínimos cuadrados ordinarios (OLS) y el análisis de componentes principales (PCA). Se utiliza para modelar la relación entre un conjunto de variables predictoras (X) y uno o más conjuntos de variables de respuesta (Y), siendo particularmente útil en situaciones donde hay un gran número de variables predictoras, multicolinealidad (altas correlaciones entre las variables predictoras), o cuando el número de predictoras excede el número de observaciones.

La idea fundamental de PLSR es encontrar un conjunto de componentes latentes (también conocidos como “factores” o “variables latentes”) tanto en el espacio de las variables X como en el de las variables Y. Estos componentes se construyen de tal manera que maximizan la covarianza entre las variables predictoras y las variables de respuesta. A diferencia de PCA, que solo busca componentes que expliquen la máxima varianza en X, PLSR busca componentes que sean relevantes para explicar la varianza en X y que también estén altamente correlacionados con Y. Una vez que se extraen estos componentes, se realiza una regresión de mínimos cuadrados ordinarios de Y sobre estos componentes latentes.

El proceso general de PLSR implica:

-

Extracción de Componentes Latentes: PLSR construye iterativamente un conjunto de componentes latentes. En cada paso:

- Identifica una combinación lineal de las variables X (un componente de X) y una combinación lineal de las variables Y (un componente de Y) que tienen la mayor covarianza entre sí.

- Estos componentes representan las direcciones en el espacio de datos que explican la mayor cantidad de la relación entre X y Y.

- Una vez que se extrae un componente, la varianza explicada por ese componente se “deflacta” (se elimina) de las matrices X e Y, y el proceso se repite con los residuos para encontrar el siguiente componente ortogonal.

- Identifica una combinación lineal de las variables X (un componente de X) y una combinación lineal de las variables Y (un componente de Y) que tienen la mayor covarianza entre sí.

- Regresión: Una vez que se ha determinado el número óptimo de componentes latentes (a menudo a través de validación cruzada), se realiza una regresión lineal estándar de las variables Y sobre estos componentes latentes de X.

Ventajas clave de PLSR:

-

Manejo de Multicolinealidad: Es muy efectivo en la reducción de dimensionalidad y el manejo de predictoras altamente correlacionadas, donde la regresión OLS fallaría o produciría estimaciones inestables.

-

Manejo de Datos de Alta Dimensionalidad: Funciona bien cuando el número de variables predictoras es mayor que el número de observaciones.

- Enfoque Predictivo: Se centra en desarrollar modelos con una fuerte capacidad predictiva.

Aprendizaje Global vs. Local:

La Regresión por Mínimos Cuadrados Parciales (PLSR) se considera un modelo de aprendizaje global.

- Aspecto Global: PLSR construye un modelo lineal global que relaciona las variables predictoras con la variable de respuesta a través de sus componentes latentes. Los componentes PLS se derivan de la estructura de covarianza de todas las variables (tanto predictoras como de respuesta) en el conjunto de datos completo, y el modelo de regresión final se ajusta sobre estos componentes, generando una ecuación que se aplica de manera consistente a cualquier nueva observación. No se ajustan modelos separados para diferentes vecindarios de datos; en cambio, se busca una transformación global de los datos que facilite la predicción.

Si bien PLSR no es un método de regresión ponderada localmente como LOESS (que ajusta modelos simples a subconjuntos locales de datos), comparte con ellos el objetivo de modelar relaciones complejas. Sin embargo, lo hace de una manera diferente. En lugar de dividir el espacio de características y aplicar modelos locales, PLSR transforma el espacio de características de forma global para encontrar una representación de menor dimensionalidad que sea óptima para la predicción. Cuando los datos no se distribuyen linealmente, PLSR puede no ser la herramienta más adecuada en su forma lineal básica, ya que sigue siendo una técnica lineal. Sin embargo, al encontrar las direcciones más relevantes en el espacio de los datos, puede capturar aspectos importantes de la estructura de los datos que son útiles incluso si la relación subyacente es no lineal. Para manejar la no linealidad explícitamente, existen extensiones como Nonlinear Partial Least Squares (NPLS) o Kernel PLS (KPLS), que introducen funciones kernel para mapear los datos a un espacio de características de mayor dimensión donde la relación podría ser linealmente modelable por PLS.

| Guía rápida para elegir PLSR | ||

| Partial Least Squares Regression (PLSR) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

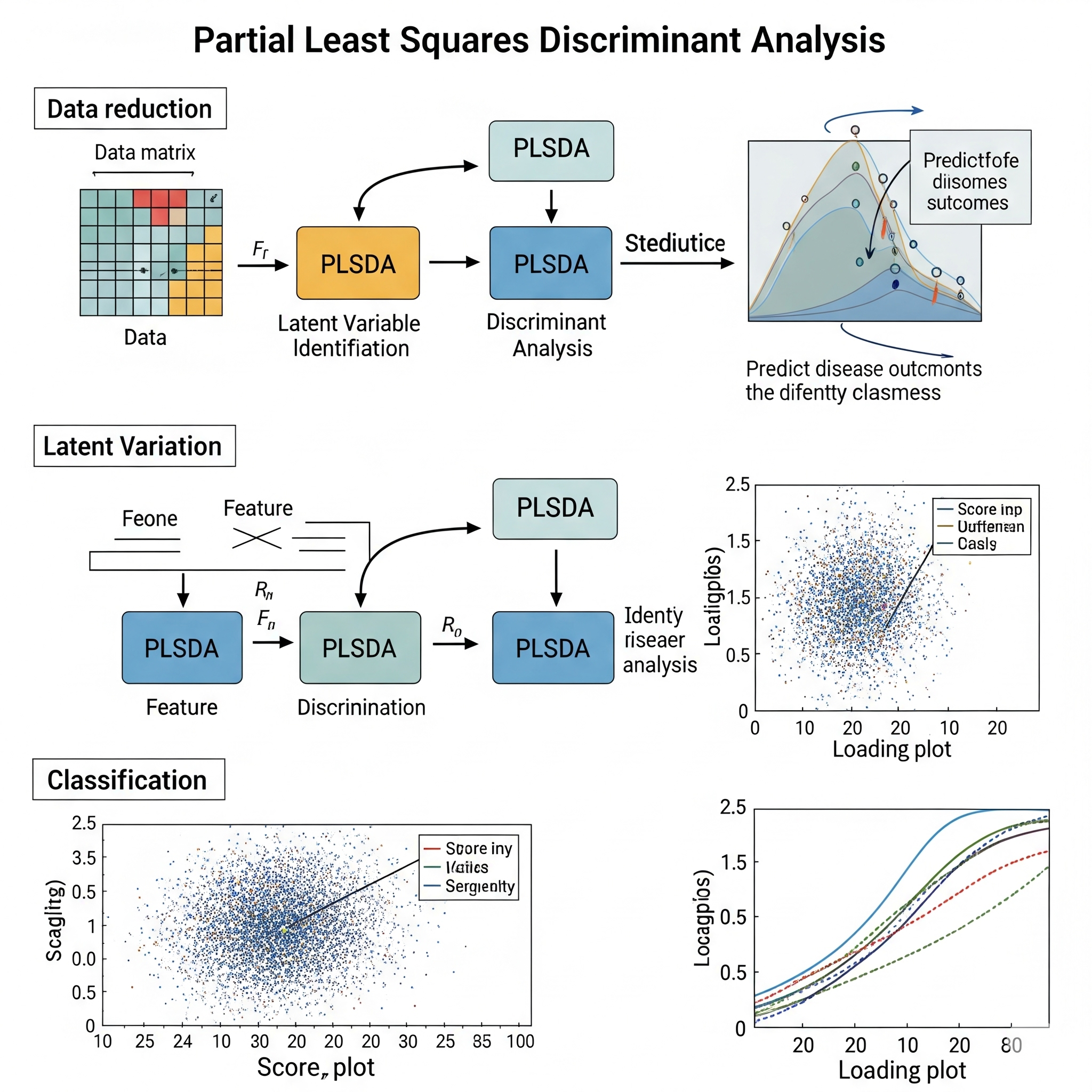

Partial Least Squares Discriminant Analysis (PLSDA)

El Análisis Discriminante de Mínimos Cuadrados Parciales (PLSDA) es una extensión del algoritmo de Regresión por Mínimos Cuadrados Parciales (PLSR), adaptada para problemas de clasificación. Al igual que PLSR, PLSDA es particularmente útil cuando se tienen muchas variables predictoras (X) y estas están altamente correlacionadas (multicolinealidad), situaciones comunes en campos como la metabolómica, la proteómica o la espectroscopia.

En esencia, PLSDA transforma un problema de clasificación en un problema de regresión. Esto se logra de la siguiente manera:

- Codificación de la Variable de Clase: La variable de respuesta categórica (la clase a la que pertenece una observación) se transforma en una o más variables numéricas. Por ejemplo, en un problema de clasificación binaria, una clase puede codificarse como ‘0’ y la otra como ‘1’. Para múltiples clases, se puede usar una codificación “one-hot encoding” (ej., [1,0,0] para Clase A, [0,1,0] para Clase B, etc.).

- Extracción de Componentes Latentes: Similar a PLSR, PLSDA construye componentes latentes (factores PLS) que son combinaciones lineales de las variables predictoras. Estos componentes se eligen para maximizar la covarianza entre las variables predictoras y las variables de respuesta codificadas. Esto asegura que los componentes capturen la varianza en X que es relevante para la separación de clases en Y.

- Clasificación: Una vez que se han obtenido los componentes PLS y se ha realizado la regresión sobre ellos para predecir los valores codificados de la clase, se aplica una regla de decisión (por ejemplo, un umbral o un clasificador lineal simple) a las predicciones para asignar cada observación a una clase. Si se usa codificación one-hot, la observación se asigna a la clase con el valor predicho más alto.

PLSDA es ventajoso porque puede manejar conjuntos de datos con muchas más variables que observaciones (problemas \(p \gg n\)), y es robusto a la multicolinealidad.

Aprendizaje Global vs. Local:

El Análisis Discriminante de Mínimos Cuadrados Parciales (PLSDA) es un modelo de aprendizaje global.

Aspecto Global: PLSDA busca una transformación lineal global de las variables predictoras a componentes latentes, y luego una relación lineal global entre esos componentes y la variable de respuesta codificada (clase). Los componentes PLS se derivan de la estructura de covarianza de todo el conjunto de datos, y el modelo de regresión final (que se usa para la clasificación) se aplica de manera consistente a cualquier nueva observación. La frontera de decisión implícita en PLSDA es típicamente lineal en el espacio de los componentes PLS (y por lo tanto lineal o una combinación lineal de las variables originales), lo que resulta en un clasificador que opera globalmente en el espacio de características.

Enfoque en la Relevancia Global: Aunque reduce la dimensionalidad y selecciona componentes que son relevantes para la respuesta, la solución final es un mapeo y una regla de decisión que son válidos para todo el dominio de los datos. No ajusta modelos locales para diferentes regiones del espacio de características. Por lo tanto, PLSDA es una técnica eficiente para encontrar patrones globales de separación de clases en presencia de alta dimensionalidad y multicolinealidad, pero si las relaciones entre las variables y las clases son inherentemente no lineales o tienen estructuras muy complejas que no pueden ser capturadas por una transformación lineal, su capacidad puede ser limitada.

| Guía rápida para elegir PLSDA | ||

| Partial Least Squares Discriminant Analysis (PLSDA) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

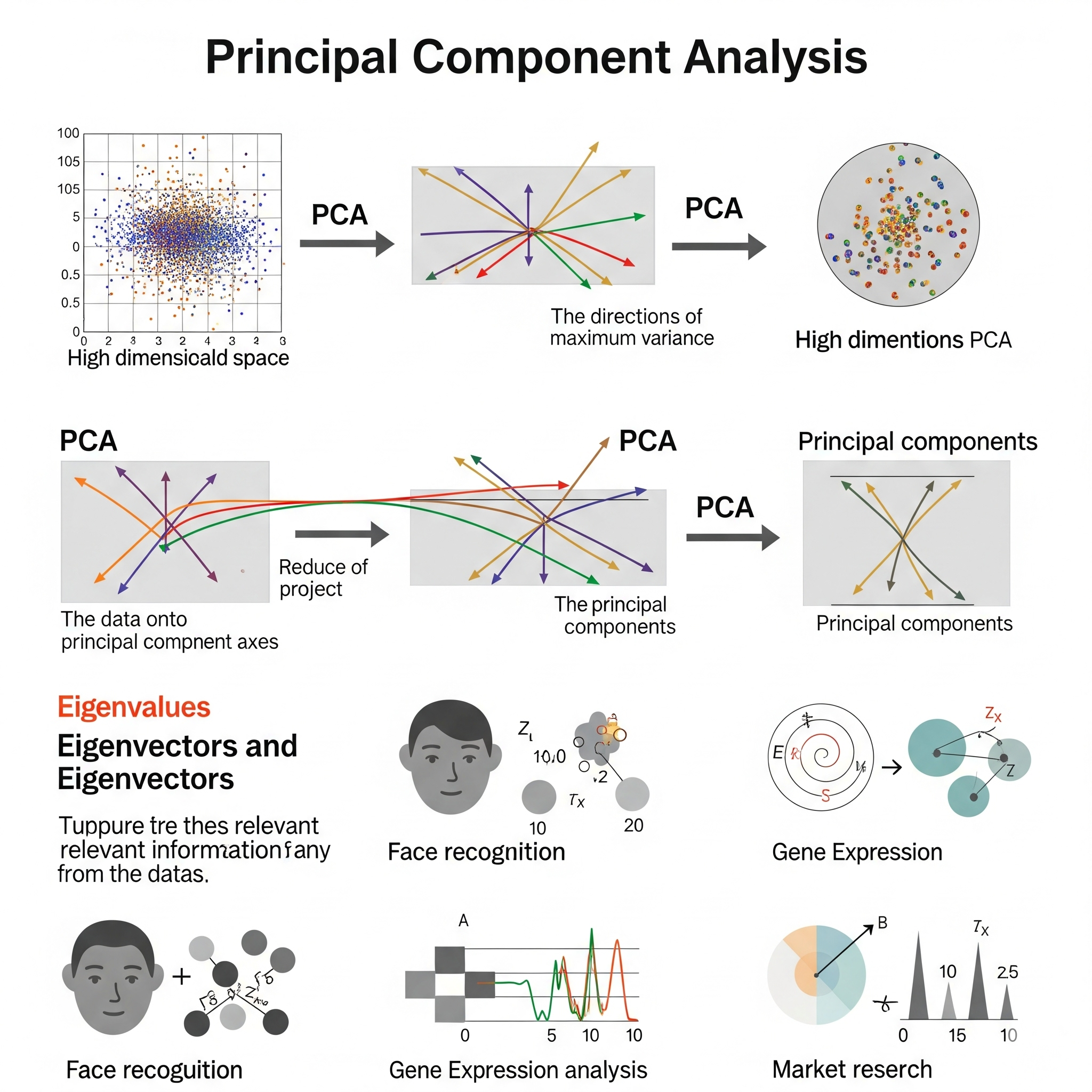

Principal Component Analysis (PCA)

El Análisis de Componentes Principales (PCA) es una técnica fundamental de reducción de dimensionalidad no supervisada. Su objetivo principal es simplificar conjuntos de datos complejos con muchas variables, transformándolos en un conjunto más pequeño de nuevas variables, llamadas componentes principales, sin perder demasiada información. Estos componentes principales son combinaciones lineales de las variables originales y son ortogonales (no correlacionados) entre sí.

PCA funciona identificando las direcciones en el espacio de datos donde la varianza es máxima. La primera componente principal (PC1) captura la mayor cantidad de varianza posible en los datos. La segunda componente principal (PC2) captura la mayor varianza restante, sujeta a ser ortogonal a la primera, y así sucesivamente. De esta manera, PCA organiza la varianza en los datos en un conjunto jerárquico de componentes.

Los usos comunes de PCA incluyen: * Reducción de dimensionalidad: Disminuir el número de variables en un dataset, lo que puede acelerar los algoritmos de Machine Learning y reducir el riesgo de sobreajuste. * Visualización de datos: Proyectar datos de alta dimensión en 2D o 3D para facilitar su visualización y la identificación de patrones, clusters o outliers. * Denoising: Eliminar el ruido de los datos al retener solo los componentes principales que capturan la señal real.

Aprendizaje Global vs. Local:

El Análisis de Componentes Principales (PCA) es un modelo de aprendizaje puramente global.

- Aspecto Global: PCA busca una transformación lineal global del espacio de características. Los componentes principales se derivan de la matriz de covarianza (o correlación) de todo el conjunto de datos. Esto significa que las direcciones de máxima varianza se determinan considerando la estructura de dispersión general de todos los puntos de datos. El conjunto de componentes principales que se obtiene es un sistema de coordenadas global al que se proyecta cualquier punto de datos. No se ajustan diferentes transformaciones para distintas regiones o vecindarios de datos; en su lugar, se aprende una única proyección que se aplica uniformemente a todo el dominio.

Por lo tanto, si la estructura de los datos es consistentemente lineal o tiene relaciones de varianza que se extienden linealmente a lo largo del espacio, PCA funcionará muy bien. Sin embargo, si los datos tienen estructuras no lineales complejas (por ejemplo, datos que forman una espiral o una esfera), PCA puede tener limitaciones para capturar estas relaciones, ya que solo busca direcciones lineales de máxima varianza.

| Guía rápida para elegir PCA | ||

| Principal Component Analysis (PCA) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

Principal Component Regression (PCR)

La Regresión de Componentes Principales (PCR) es un método de regresión que combina el Análisis de Componentes Principales (PCA) con la Regresión por Mínimos Cuadrados Ordinarios (OLS). Su principal utilidad radica en situaciones donde se tienen muchas variables predictoras (X) y existe una alta multicolinealidad (fuerte correlación entre ellas), lo que puede hacer que los modelos de regresión OLS sean inestables o ineficientes.

El proceso de PCR consta de dos pasos principales:

- Reducción de Dimensionalidad con PCA: Primero, se aplica PCA a las variables predictoras (X) para transformarlas en un conjunto más pequeño de componentes principales. Estos componentes son combinaciones lineales no correlacionadas de las variables originales y capturan la mayor parte de la varianza en las variables X. Se selecciona un subconjunto de estos componentes principales (aquellos que explican la mayor parte de la varianza total) para retener. Es importante destacar que, en este paso, PCA no tiene conocimiento de la variable de respuesta (Y); solo se enfoca en la estructura de las variables X.

- Regresión OLS sobre Componentes: Una vez que se han obtenido los componentes principales seleccionados, se realiza una regresión lineal estándar (OLS) de la variable de respuesta (Y) sobre estos componentes. Como los componentes principales son ortogonales, la multicolinealidad ya no es un problema en este paso de regresión.

El beneficio de PCR es que permite construir un modelo de regresión en escenarios con multicolinealidad severa, reduciendo el número de variables a un conjunto más manejable y estable, mientras se intenta preservar la mayor cantidad de información de las variables predictoras.

Aprendizaje Global vs. Local:

La Regresión de Componentes Principales (PCR) es un modelo de aprendizaje global.

-

Aspecto Global: Ambos pasos de PCR son intrínsecamente globales.

- PCA (Paso Global): Como se mencionó anteriormente, PCA es una técnica global que encuentra una transformación lineal de los datos que se aplica de manera uniforme a todo el espacio de características. Los componentes principales se derivan de la estructura de varianza global de las variables predictoras.

- OLS (Paso Global): La regresión realizada sobre los componentes principales es un modelo OLS estándar, que también es una técnica global. Busca una única relación lineal que se aplica a todos los datos transformados.

En conjunto, PCR construye una función de regresión global que mapea el espacio de características original (transformado a componentes principales) a la variable de respuesta. La solución resultante es una ecuación que se aplica de manera consistente para todas las observaciones, sin ajustar modelos diferentes para subconjuntos locales de datos. Esto significa que si la relación entre las variables predictoras y la respuesta es no lineal o cambia drásticamente en diferentes regiones del espacio de características, PCR podría no ser la opción más flexible, ya que se basa en transformaciones y regresiones lineales globales.

| Guía rápida para elegir PCR | ||

| Principal Component Regression (PCR) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

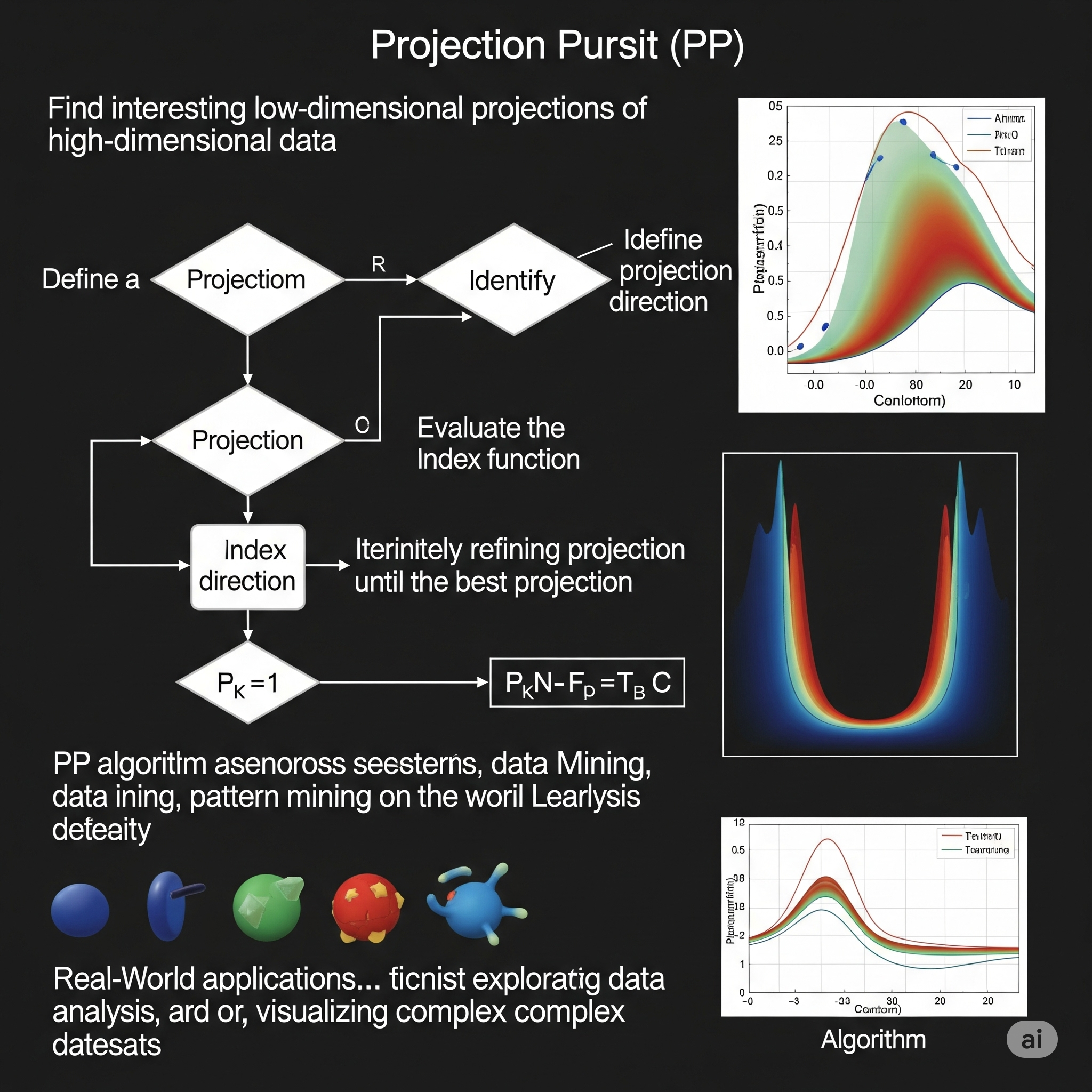

Projection Pursuit (PP)

Projection Pursuit (PP) es una técnica estadística de reducción de dimensionalidad y análisis exploratorio de datos utilizada para encontrar las proyecciones “más interesantes” de datos multivariados de alta dimensión en un espacio de menor dimensión (generalmente 1D o 2D). La clave de PP es que las proyecciones “interesantes” son aquellas que se desvían más de una distribución normal (gaussiana), ya que las estructuras como agrupaciones, valores atípicos, o formas inusuales tienden a ser más evidentes en proyecciones no gaussianas.

El algoritmo de PP no busca simplemente la mayor varianza (como PCA), sino que intenta encontrar direcciones de proyección que revelen la estructura subyacente y las características no lineales de los datos. Lo hace maximizando un “índice de proyección” que mide la “interesante” o la “no-gaussianidad” de la proyección. Diferentes índices pueden enfocarse en diferentes aspectos, como la asimetría, la curtosis, o la presencia de múltiples modos (grupos).

Existen variantes de PP para diferentes propósitos, como: * Exploratory Projection Pursuit (EPP): Para visualización y detección de estructuras. * Projection Pursuit Regression (PPR): Para construir modelos de regresión no lineales. * Projection Pursuit Classification (PPC): Para tareas de clasificación.

Aprendizaje Global vs. Local:

Projection Pursuit (PP) se puede considerar como un modelo que combina aspectos de aprendizaje global y local, con un fuerte énfasis en la detección de características locales en un contexto global.

Aspecto Global: PP busca una transformación lineal global (la dirección de proyección) que se aplica a todo el conjunto de datos para encontrar las proyecciones “más interesantes”. La optimización del índice de proyección se realiza sobre todo el espacio de características para identificar estas direcciones. Las funciones resultantes (como en PPR o PPC) son combinaciones de funciones no lineales aplicadas a estas proyecciones globales.

Aspecto Local (al revelar estructuras): Donde PP exhibe un carácter “local” es en su capacidad para resaltar estructuras que son intrínsecamente locales (como clusters o valores atípicos) que podrían estar ocultas en las altas dimensiones o en proyecciones puramente globales (como PCA). Al buscar desviaciones de la normalidad, PP es capaz de “perseguir” (de ahí “pursuit”) las direcciones que exponen agrupaciones densas o huecos en los datos, que son fenómenos locales. La idea es que si los datos no se distribuyen linealmente o tienen estructuras complejas, PP puede encontrar proyecciones donde la “densidad” o “forma” local de los datos es más informativa, permitiendo al usuario o a un algoritmo posterior identificar estas estructuras que son una forma de “regresión ponderada localmente” o un análisis local de patrones.

En resumen, PP es una técnica potente para explorar la estructura de datos de alta dimensión, especialmente cuando las relaciones son no lineales o complejas. Si bien el proceso de búsqueda de proyecciones es global, el “interés” de estas proyecciones a menudo radica en su capacidad para revelar características locales y no gaussianas que son cruciales para entender los datos.

| Guía rápida para elegir PP | ||

| Projection Pursuit (PP) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

Sammon Mapping

Sammon Mapping es una técnica de reducción de dimensionalidad no lineal que se utiliza para visualizar datos de alta dimensión en un espacio de menor dimensión (generalmente 2D o 3D). Su principal objetivo es preservar la estructura de distancia local de los datos originales en la representación de menor dimensión.

A diferencia de técnicas como PCA que buscan preservar la varianza global (y por lo tanto las distancias euclidianas globales), Sammon Mapping se enfoca en que las distancias pequeñas (entre puntos cercanos) en el espacio original sean representadas con mayor fidelidad en el espacio reducido que las distancias grandes. Esto lo hace particularmente bueno para revelar agrupaciones o clusters que podrían estar ocultos en proyecciones lineales o en otras técnicas de reducción de dimensionalidad que no priorizan las distancias locales.

El algoritmo de Sammon Mapping funciona minimizando una función de “error” o “estrés” específica, conocida como el “estrés de Sammon”. Esta función penaliza más fuertemente las grandes discrepancias en las distancias pequeñas que las grandes discrepancias en las distancias grandes. La minimización de esta función se realiza mediante un proceso iterativo de descenso de gradiente.

Aprendizaje Global vs. Local:

Sammon Mapping es un modelo que exhibe un fuerte carácter de aprendizaje local, aunque la optimización se realiza sobre la totalidad de los datos.

Aspecto Local: La característica distintiva de Sammon Mapping es su énfasis en la preservación de las distancias locales. Al penalizar más las distancias pequeñas que se deforman en la proyección, el algoritmo se esfuerza por mantener a los puntos que estaban cerca en el espacio original, cerca en el espacio de menor dimensión. Esto es crucial para revelar la estructura local y las agrupaciones dentro de los datos. Es como si el algoritmo estuviera haciendo una serie de “regresiones ponderadas localmente” para cada vecindario de puntos, ajustando las posiciones en el mapa de baja dimensión para que las relaciones cercanas se mantengan. Esta prioridad en las relaciones de vecindad es una marca del aprendizaje local.

Optimización Global: A pesar de su enfoque local, la función de estrés de Sammon se calcula y se minimiza sobre todos los pares de puntos en el conjunto de datos. La solución final es una configuración global de puntos en el espacio de baja dimensión. Por lo tanto, el proceso de optimización es global, pero su criterio de “mejor ajuste” da una importancia desproporcionada a la preservación de las relaciones locales.

En resumen, Sammon Mapping es una técnica poderosa para visualizar datos de alta dimensión, especialmente cuando los clusters o las estructuras locales son importantes. Si los datos no se distribuyen linealmente y lo que se busca es entender cómo se agrupan los puntos en sus vecindarios, Sammon Mapping ofrece una representación donde las relaciones locales son el foco principal, lo que lo convierte en una excelente herramienta para la exploración de estructuras no lineales y la detección de agrupaciones.

| Guía rápida para elegir sammon mapping | ||

| Sammon Mapping | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

Regularized Discriminant Analysis (RDA)

El Análisis Discriminante Regularizado (RDA) es un método de clasificación que actúa como un intermedio flexible entre el Análisis Discriminante Lineal (LDA) y el Análisis Discriminante Cuadrático (QDA). Fue desarrollado por Jerome Friedman para abordar las limitaciones de LDA (que asume covarianzas iguales para todas las clases, lo que resulta en fronteras lineales) y QDA (que permite covarianzas separadas pero puede ser inestable con pocos datos o muchas variables).

RDA introduce dos parámetros de regularización, \(\alpha\) y \(\gamma\), que controlan la flexibilidad del modelo y su capacidad para adaptarse a los datos:

-

Parámetro \(\alpha\) (alpha): Controla el grado en que la matriz de covarianza de cada clase se contrae hacia una matriz de covarianza común (como en LDA).

- Si \(\alpha = 0\), RDA se comporta como QDA (cada clase tiene su propia matriz de covarianza).

- Si \(\alpha = 1\), RDA se comporta como LDA (todas las clases comparten una matriz de covarianza común).

- Para valores entre 0 y 1, RDA utiliza un promedio ponderado de la matriz de covarianza específica de la clase y la matriz de covarianza común. Esto ayuda a estabilizar las estimaciones de covarianza en QDA, especialmente cuando los tamaños de muestra son pequeños o el número de variables es grande.

-

Parámetro \(\gamma\) (gamma): Controla el grado en que la matriz de covarianza (ya sea común o específica de la clase, dependiendo de \(\alpha\)) se contrae hacia una matriz diagonal.

- Si \(\gamma = 0\), no hay contracción diagonal adicional.

- Si \(\gamma = 1\), la matriz de covarianza se contrae completamente a una matriz diagonal (lo que implica independencia entre las variables).

- Para valores entre 0 y 1, se aplica una contracción hacia la diagonal, lo que puede ser útil cuando hay multicolinealidad.

Al sintonizar estos dos parámetros (generalmente mediante validación cruzada), RDA puede encontrar un equilibrio óptimo entre la simplicidad de LDA y la flexibilidad de QDA, adaptándose mejor a la estructura de covarianza real de los datos y mejorando la estabilidad del modelo.

Aprendizaje Global vs. Local:

El Análisis Discriminante Regularizado (RDA) es un modelo de aprendizaje global que incorpora un grado de adaptación local a través de su regularización.

Aspecto Global: Al igual que LDA y QDA, RDA construye un clasificador global basado en las distribuciones de probabilidad modeladas para cada clase. Las matrices de covarianza regularizadas y las medias de las clases se estiman a partir de todo el conjunto de datos de entrenamiento, y la regla de clasificación resultante se aplica de manera consistente en todo el espacio de características. La frontera de decisión que RDA define es una función global (que puede ser lineal o cuadrática, o una combinación de ambas, dependiendo de los parámetros de regularización).

Adaptación Local (a través de la regularización de covarianza): La flexibilidad de RDA para ajustarse mejor a los datos que LDA o QDA proviene de su capacidad para modelar las estructuras de covarianza de las clases de una manera más matizada. Al permitir una contracción parcial de las matrices de covarianza hacia una común (parámetro \(\alpha\)) o hacia una diagonal (parámetro \(\gamma\)), RDA puede adaptar las formas de las distribuciones de las clases. Esto permite que el modelo capture mejor las características de dispersión de los datos en diferentes regiones, lo que en última instancia se traduce en fronteras de decisión más adaptables que pueden manejar cierto grado de no linealidad o formas complejas de clase. No es un ajuste local en el sentido de LOESS, sino una forma de adaptar la complejidad del modelo global a la estructura de covarianza percibida de cada clase.

| Guía rápida para elegir RDA | ||

| Regularized Discriminant Analysis (RDA) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||

Uniform Manifold Approximation and Projection (UMAP)

Uniform Manifold Approximation and Projection (UMAP) es una técnica de reducción de dimensionalidad no lineal de vanguardia, utilizada principalmente para la visualización de datos de alta dimensión y para el aprendizaje de características (feature learning). Fue desarrollada por Leland McInnes, John Healy y James Melville. UMAP es una alternativa más reciente y a menudo más rápida y escalable a t-SNE (t-Distributed Stochastic Neighbor Embedding), manteniendo su capacidad para preservar la estructura local y global de los datos.

La idea central de UMAP se basa en la teoría de los conjuntos difusos (fuzzy set theory) y la geometría riemanniana. Intenta construir una representación de baja dimensión de los datos asumiendo que los datos de alta dimensión residen en una variedad (manifold) subyacente de baja dimensión. El algoritmo opera en dos fases:

-

Construcción del Grafo de Vecindad Difusa:

- Primero, UMAP construye un grafo ponderado difuso en el espacio de alta dimensión. Los nodos del grafo son los puntos de datos y los pesos de las aristas representan la probabilidad de que dos puntos estén conectados (es decir, qué tan similares o cercanos son).

- Para ello, UMAP estima las distancias entre los puntos en el manifold subyacente y luego convierte estas distancias en probabilidades de conectividad. Esto es crucial porque le permite adaptarse a la densidad local de los datos (puntos en regiones densas pueden estar cerca incluso con distancias euclidianas grandes, y viceversa en regiones dispersas).

-

Optimización del Diseño en Baja Dimensión:

- Luego, UMAP optimiza el diseño de los puntos en un espacio de baja dimensión (ej., 2D) para que la estructura del grafo construido en alta dimensión sea lo más similar posible al grafo construido en baja dimensión.

- Esto se logra minimizando una función de costo que intenta hacer que las probabilidades de conectividad en el espacio de baja dimensión coincidan con las probabilidades de conectividad del grafo de alta dimensión.

UMAP es valorado por su velocidad, escalabilidad a grandes conjuntos de datos, y su capacidad para preservar simultáneamente la estructura local y global de los datos, lo que lo hace ideal para visualizar agrupaciones y relaciones complejas.

Aprendizaje Global vs. Local:

UMAP es un excelente ejemplo de un modelo que logra un equilibrio sofisticado entre el aprendizaje local y global.

Aspecto Local: UMAP pone un fuerte énfasis en la preservación de la estructura local. Al construir el grafo de vecindad difusa, se enfoca en las relaciones de los vecinos más cercanos de cada punto (controlado por el parámetro

n_neighbors). La forma en que calcula las probabilidades de conectividad se adapta a la densidad local de los datos, asegurando que los clústeres y las agrupaciones cercanas se mantengan cohesivos en la representación de baja dimensión. Las relaciones “locales” son las que definen el “manifold” en primera instancia. Esto significa que si los datos no se distribuyen linealmente y tienen estructuras complejas con vecindarios distintos (como diferentes clusters o ramas en una estructura), UMAP es capaz de capturarlas con alta fidelidad, de forma similar a como una “regresión ponderada localmente” operaría en cada vecindario.Aspecto Global: A pesar de su énfasis local, UMAP también hace un esfuerzo consciente por preservar la estructura global de los datos. Al minimizar la función de costo para que la estructura del grafo se mantenga en el espacio de baja dimensión, UMAP no solo se asegura de que los puntos cercanos permanezcan cercanos, sino que también intenta que los grupos de puntos que estaban globalmente separados en la alta dimensión permanezcan separados en la baja dimensión. El parámetro

min_distayuda a controlar cuán compactos deben ser los clústeres, lo que influye en la separación global. Esta capacidad de equilibrar ambos aspectos es una de las principales ventajas de UMAP sobre técnicas que a veces sacrifican la estructura global (como t-SNE, que puede “romper” grandes clústeres).

| Guía rápida para elegir UMAP | ||

| Uniform Manifold Approximation and Projection (UMAP) | ||

| Criterio | Aplica | Detalles |

|---|---|---|

| Fuente: Elaboración propia | ||